2017-365

De Mi caja de notas

« Mon temps dans l'existence est mon seul capital. »

Intelligence artificielle

Enfin un article qui ne dit pas n'importe quoi à l'égard de l'AI et qui a le mérite de rappeler que sur bien des plans on en est réduit à des spéculations https://t.co/yImFdZTuI1

— Gilles Babinet (@babgi) 30 décembre 2017

Source Fichier:IA-Le-Monde-2017-12-31.pdf

Les machines surpassent déjà l’homme dans certaines tâches, suscitant à la fois craintes et espoirs. Huit pages pour faire le tri entre perspectives séduisantes et risques Bien réels

L'intelligence artificielle (IA) est à la mode. Rien que dans Le Monde et sur Lemonde.fr, le sujet a été évoqué dans 200 articles en 2017, soit presque 15 % de plus qu’en 2016. Il en a été question dans tous les domaines : en économie, en science, et même en politique, puisque le Premier ministre, Édouard Philippe, a confié une mission sur la question au député (LRM) mathématicien Cedric Villani, dont les conclusions sont attendues en janvier.Il reste à savoir ce que cache ce terme. Bien sûr, il y a ces fantastiques percées montrant que des machines surpassent désormais l’homme dans des tâches spe-cifiques. Dans le secteur de la santé, elles repèrent mieux que les médecins des mélanomes ou des tumeurs du sein sur des images médicales. Dans le transport, elles causent moins d’accidents que des chauffeurs. Sans compter les autres avances : la reconnaissance vocale, l’art du jeu (poker, jeu de go), l’écriture, la peinture ou la musique. En coulisse de ce monde si particulier s’activent les géants du numérique (Google, Facebook, Amazon, Microsoft, IBM, Baidu...) ou des start-ups désireuses de leur voler la vedette.

Ces développements posent question. Les conséquences sur l’emploi inquiètent, celles sur la responsabilité légale en cas de bug paraissent sans réponse. Sans oublier la protection de la vie privée face à ces robots capables de tout voir, tout entendre, tout prévoir (ou presque) et d’envoyer les données ainsi récoltées sur les serveurs d’entreprises dont on ne sait pas toujours ce qu’elles en feront. Déjà, les dérapages ne manquent pas. Des informaticiens n’ont-ils pas mis au point un système de détection de l’orientation sexuelle à partir de simples photos de personnes ?

« Je n’arrête pas de tirer la sonnette d’alarme, mais tant que les gens ne verront pas des robots descendre dans la rue pour tuer tout le monde, ils ne sauront pas comment réagir », déclarait à l’été 2017 Elon Musk, le patron du constructeur automobile Tesla et de l’entreprise spatiale Spa-ceX. Ces propos ont déclenche la réaction cinglante du patron de Facebook, Mark Zuckerberg, qui les a qualifies d’« irresponsables » et s’est empressé de vanter les avancées promises selon lui par l’IA. « J’ai discuté avec Mark [Zuckerberg] de tout cela, a répondu Elon Musk sur Twitter. Sa compréhension du sujet est limitée. »

L’IA échauffe tant les esprits qu’il devient nécessaire de faire le tri entre fantasmes et réalité, promesses séduisantes et risques bien reels.

- L’emploi menacé ?

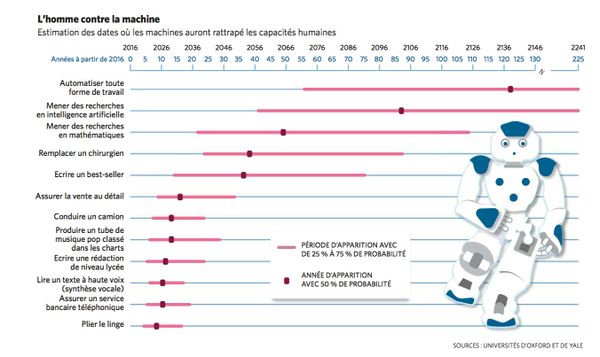

C’est l’une des craintes récurrentes. Ces technologies vont-elles rendre l’humain obsolète pour certains métiers ? Rien n’est sûr. Plusieurs études sérieuses – mais contradictoires – ont été publiees à ce sujet. En 2013, des chercheurs d’Oxford estimaient que 47% des emplois américains étaient menaces. Trois ans plus tard, l’Organisation de coopération et de développement économique (OCDE) affirmait que seuls 9 % des emplois étaient menaces dans les 35 pays qui la composent.

« Les études s’interessent juste au phenomène de destructions brutes d’emplois », soulignait Marie-Claire Carrère-Gee, presidente du Conseil d’orientation pour l’emploi, lors d’une audition au Sénat le 19 janvier 2017. D’après elle, ces recherches ont le tort de ne pas tenir compte de l’éventuel effet positif de ces technologies sur les créations d’emplois ou la transformation d’emplois existants : « A chaque grande vague d’innovation technologique, il y a la crainte d’un chômage massif. Or, l’histoire montre que, depuis toujours, le progrès technologique a crée des emplois, y compris ces dernières annees. » Impossible, donc, de prevoir avec certitude l’impact de l’IA dans ce domaine dans les annees à venir.

- Des données biaisées ?

Un certain nombre des technologies d’IA « ap-prennent » et s’enrichissent à partir d’enormes bases de donnees creees par des humains. Un exemple : si l’on fournit 10 000 CV à la machine en lui indiquant lesquels ont permis à leur auteur d’obtenir un entretien d’embauche, elle les analy-sera tous et finira par retenir les mtimes criteres de tri que l’titre humain. Or, ces lots de donnees sont souvent biaises. Resultat : plusieurs programmes ont déjà montre qu’ils reproduisaient le racisme ou le sexisme des humains.

Ainsi, quand un programme d’IA est devenu jury d’un concours de beaute en 2016, il a elimine la plupart des candidats noirs. Une autre techno-logie, censee emettre des liens entre les mots, a reproduit certains stereotypes, en associant par exemple les femmes au foyer et les hommes aux professions scientifiques... Autre probleme : en septembre 2017, deux chercheurs de l’universite Stanford (Californie) ont annonce avoir cree un programme capable, d’apres eux, de reconnaître l’homosexualite sur le visage.

L’IA apprend donc de nos propres prejuges pour mieux les... reproduire. Comment y remedier ? Si les bases de donnees sont biaisees, c’est aussi, selon Emmanuel Mogenet, directeur de Google Research Europe, parce qu’elles sont souvent incompletes, et trop peu representatives des minorites. « Il faut trouver les endroits où nous n’avons pas recolte as-sez de donnees, expliquait-il au Monde en avril 2017. C’est un problème sur lequel on se penche, qui nous preoccupe enormement, car on veut des modèles qui n’ignorent pas les minorites. Ça avance. »

- Vers un « piratage » de l’esprit humain ?

Eric Horvitz le dit sans detour : il craint « des atta-ques de l’IA sur l’esprit humain ». Ce specialiste du sujet, directeur de Microsoft Research Lab, a liste, au festival SXSW organise en mars 2017 à Austin (Texas), les dangers potentiels auxquels il faudrait, selon lui, reflechir des aujourd’hui. Ce qu’il entend par « attaques » n’a rien à voir avec un delire cyber-punk d’implantation de technologies dans le cer-veau. Le danger, pour lui, est bien plus concret, et déjà là. Il evoque notamment des programmes d’IA capables de rediger un Tweet personnalise, « specialement conçu » pour une personne, en s’inspirant de son comportement en ligne. « Sur quoi tweete-t-elle ? Quand est-ce qu’elle repond ? A quels evenements a-t-elle participe ? Ces infos peu-vent titre utilisees pour concevoir un Tweet tel qu’il est quasi impossible pour [la personne] de ne pas cli-quer. » Une nouvelle etape pour la publicite ciblee, mais pas seulement. « Des entreprises utilisent ces donnees pour personnaliser des messages, mais aussi pour influencer la façon dont les gens votent, comme Cambridge Analytica ». Cette start-up bri-tannique affirme avoir joue un rôle dans la victoire electorale de Donald Trump.

Eric Horvitz s’inquiete egalement du risque des « fake news », de fausses informations montees de toutes pieces, qui pourraient beneficier de ces technologies. Des programmes sont déjà capables de faire dire ce que l’on veut à Barack Obama ou à Vladimir Poutine, en video.

- Interdire les armes autonomes ?

Aujourd’hui, rien ne s’oppose techniquement à la creation d’armes letales autonomes. Mais les ar-mees affirment que les machines utilisees sont toujours contrôlees à distance par un humain et que jamais aucune ne « prend la decision de ti-rer ». Sauf qu’aucune reglementation internatio-nale n’interdit l’usage d’armes letales autonomes. D’oil les discussions en cours, à l’ONU, à ce propos.

Ces technologies « existent dejà », s’inquietait en novembre 2017 Stuart Russell, professeur à l’uni-versite de Californie à Berkeley. « Elles peuvent tuer et mettraient en peril notre securite et notre liberte », ajoutait ce chercheur engage. En 2015, plus d’un millier de personnes, dont de nombreux cher-cheurs en IA, mais aussi des personnalites comme Elon Musk ou l’astrophysicien Stephen Hawking, demandaient l’interdiction de telles armes. « Les enjeux sont importants : les armes autonomes ont ete decrites comme la troisième revolution dans les techniques de guerre, après la poudre à canon et les armes nucleaires », lisait-on dans l’appel.

- Tous surveillés ?

La vision par ordinateur a connu d’importants progres ces dernieres annees grâce aux avancees du deep learning (« apprentissage automatique profond »). Des programmes sont desormais ca-pables de reconnaître les visages, de distinguer un chat d’un chien et de decrire des images. De plus en plus, ces innovations s’appliquent à la video. Ainsi, la SNCF a annonce, peu apres les attentats de novembre 2015, qu’elle experimen-tait des technologies de detection des comporte-ments suspects à partir des cameras de surveillance, en se fondant sur des criteres comme « le changement de temperature corporelle, le haussement de la voix ou le caractère saccade de gestes, qui peuvent montrer une certaine anxiete ».

Couple à des technologies de reconnaissance faciale, ce type de systeme pourrait permettre de detecter en direct une personne fichee S aban-donnant un colis suspect. Mais aussi un militant pour les droits de l’homme dans une dictature... Cela dit, ces systemes sont encore loin de fonc-tionner à la perfection et le risque d’erreurs demeure important.

- Comment protéger les données personnelles ?

Pour fonctionner, bien des programmes d’IA « s’entraînent » à partir de centaines de milliers, voire de millions, de donnees humaines. Comment sont-elles recoltees ? Les personnes concernees ont-elles accepte leur exploitation ? En avril 2017, un developpeur a publie en ligne 40 000 photos de profils d’utilisateurs de l’application de rencontres Tinder, afin qu’elles puissent servir aux specialistes de l’IA. Ces photos ont ete retirees à la demande de Tinder, dont le reglement interdit ce type d’utilisation. Google s’est aussi retrouve en difficulte apres un partenariat conclu en 2015 entre son entreprise d’IA DeepMind et les hôpitaux londoniens du service de sante britannique (NHS). Les donnees de 1,6 million de patients avaient ete fournies à Deep-Mind pour developper une application d’aide au personnel hospitalier, ce qui avait declenche une polemique outre-Manche.

- Expliquer l’inexplicable ?

Il est aujourd’hui possible de creer des programmes de proposition de diagnostic medical ou d’ap-probation d’une demande de prtit. Or, une bonne partie des decisions prises par ces programmes ne sont pas explicables. Les ingenieurs ne savent pas retracer la multitude de calculs effectues par la machine pour parvenir à sa conclusion. Autre-ment dit, si un prtit est refuse ou un CV recale, aucune justification n’est fournie. Un constat gti-nant, qui explique notamment que les technologies d’IA ne sont generalement utilisees que pour suggerer des solutions, soumises à validation humaine. Pour les chercheurs specialises, il y a là un enjeu majeur. « L’explication du comportement est très importante, c’est ce qui determine l’accepta-bilite par la societe de ces systèmes », indiquait David Sadek, directeur de la recherche à Mines-Telecom, au Senat, le 19 janvier 2017.

- Responsables mais pas coupables ?

« Si les robots se developpent, qui sera responsable ? Se posera alors la question de la reparation en cas de dommages », soulignait le depute (PS) Jean-Yves Le Deaut, le 19 janvier 2017, au Senat. Que ce soit en France ou ailleurs, la loi ne semble pas titre sur le point de changer. « Les systèmes automatises vont de plus en plus titre amenes à prendre des decisions sur des situations que n’auront pas pu predire les ingenieurs », prevenait Derek Jinks, professeur à la faculte de droit de l’universite du Texas, lors du festival SXSW en mars 2017. Quid, par exemple, des voitures autonomes ? L’interrogation hante les assureurs : si ce vehicule tue quelqu’un dans un accident, la responsabilite sera-t-elle celle du cons-tructeur, de l’ingenieur, du proprietaire de la voi-ture ou de la personne à la place du conducteur ? Des questions pressantes, et sans reponse, alors que des vehicules autonomes experimentaux ont déjà parcouru des millions de kilometres sur de vraies routes aux Etats-Unis.

- « Terminator », une fausse menace ?

« La singularite, ça m’enerve », declarait en avril 2017 Jean Ponce, chercheur en vision artifi-cielle à l’Ecole normale superieure. Il critiquait les tenants de cette theorie qui designe le moment – hypothetique – oil l’IA depassera l’intelligence de l’homme. « Je ne vois aucun indice que la machine intelligente soit plus proche de nous aujourd’hui qu’avant », assurait-il lors d’une conference organisee par Google à Paris. Dans l’imaginaire collectif, l’IA evoque le film Terminator, dans lequel les machines ont declare la guerre à l’homme.

Or, dans la realite, la grande majorite des chercheurs en IA affirment ne pas avoir la moindre idee de la façon dont pourrait titre creee une machine aussi intelligente que l’homme, capable de dialoguer naturellement, de disposer de sens commun, d’humour... Et encore moins sous la forme d’un robot humanoïde. L’idee d’une IA qui echapperait au contrôle de son createur provoque aussi des sourires en coin dans la communaute, qui peine à comprendre pourquoi certains craignent qu’un programme conçu pour jouer au jeu de go s’attaquerait sou-dain à l’espece humaine.

« C’est incroyable de constater l’intertit que cela suscite chez les gens, s’etonnait Eric Horvitz, lors du festival SXSW. Les journalistes ont tendance à diffuser un point de vue extrtime, alors que la realite est beaucoup plus nuancee que cela. » Pour lui, cela « reste des questions très interessantes (...) sur les-quelles il faut garder un œil, et il ne faut pas se moquer en disant que les gens sont fous ». Mais, souligne-t-il, « ce sont des questions de très long terme, et nous devons reflechir aux questions qui nous concernent directement, maintenant ». •

MORGANE TUAL AVEC DAVID LAROUSSERIE